Új hozzászólás Aktív témák

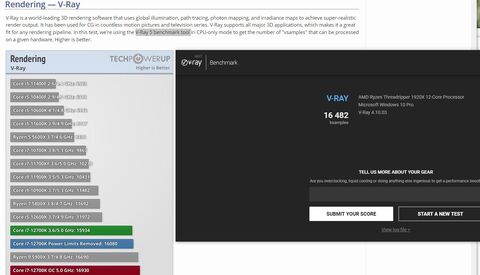

-

hallador

addikt

Na igen nincsenek meglepetések. Az AMD amint nyeregbe került elszálltak az árak.

The further a society drifts from truth, the more it will hate those that speak it. (George Orwell) [Work Machines: HP EliteBook, HP ProBook & Linux Mint 20 ; Entertainment: Apple Macbook AIR M1]

-

Meteorhead

aktív tag

Ez egész jó döntés. Így a kriptobányászok talán nem fogják lefosztani a készleteket mert hosszabb a megtérülés. (Már elfelejtettem melyik a nyomorult L3-cache-re kigyúrt kripto valuta.) Talán eljut azokhoz akikhez kell, még ha nem is a legolcsóbb módon.

-

NandoXXL

senior tag

válasz

Meteorhead

#4

üzenetére

Meteorhead

#4

üzenetére

1920X 70.000,-75.000,- Ft környékén vettem, ez új áfás ár volt, mint régebbi generáció. De 1,5 év után is már 125.000,- Ft környékén volt, tehát már kicsit tesztelt, bios updetelt lappal egész jó áron volt beszerezhető... Gondold végig, ez akkor elég komoly teljesítmény volt, memória intenzív alaklamzásokban mai napig nem panaszkodhat. Szóval, van ahol a csillám led fs..12700K meg 5900X se jobb igazán. Erre egy ideje elérhetetlen árú terméket csináltak az egészből.

-

válasz

Meteorhead

#4

üzenetére

Meteorhead

#4

üzenetére

Arra ne vegyél mérget, lehet így is lecsapnak rá, habár lehet inkább majd a 3d cache-el felgyúrt asztali ryzenek lesznek ennek áldozatai. Egyébként a raptoreum-ra gondoltál, de talán annál is meglépik hogy átportolják gpu-ra és akkor megmenekül a bányászoktól.

[ Szerkesztve ]

izé

-

Manapság sajnos ez már nem hír!

Az lenne a szenzáció, ha valami, bármi, olcsó lenne! Na az lenne hír.

-

NandoXXL

senior tag

válasz

antikomcsi

#7

üzenetére

antikomcsi

#7

üzenetére

Parancsolj, most érdemes venni:

https://www.arukereso.hu/memoria-modul-c3577/kapacitas-16-gb/?orderby=1&st=ddr4 -

tibaimp

nagyúr

Ennyi!

Ezt ugattam jó pár éve, mikor az AMD-sek állították/hitték, hogy amint az AMD is jó/gyors/ütőképes CPU-t tud készíteni, akkor is olyan olcsó marad, mint annó volt. Persze akkor én voltam a kék szemüveges rohadék....A tehén egy bonyolult állat, de ÉN megfejtem...| 2016-tól az tuti, hogy az angyalok is esznek babot...

-

hallador

addikt

Nem egészen arra gondoltam, hogy tegnap mi volt, hanem az elmúlt 30 évre, mondjuk. Másrészt a cikkben pedig mintha le lenne írva, hogy ez nem egészen a XEON processzorok ellen megy vagy?

Az Intelnek nincs ilyen processzora szerintem.

Hát azért az AMD sem jobb mint az Intel, ha a pénzről van szó... Sőt...Jó, jó, azért ez olyan mintha azt mondtad volna, hogy kell egy autó, ami Magyarországon 1 millával drágább mint Ausztriában, akkor verjem le a magyar kormányon. De igazából mindenki nagy ívben tojik az egészre, mert igazából úgy is majd az szívja meg, aki Magyarországon autót vesz. Nem tudom érted-e, ki a tökömet érdekel, hogy miért kerül többe... Tudod, ha berúgtuk volna, akkor gól lett volna, amúgy meg akkor nyerünk volna.kit érdekel hogy mi lenne ha... Engem nem.

Na igen, az AMD miután a GlobalFondried-től megszabadult, akkor sok AMD-s azt mondta a Prohardveren, hogy ennél nagyobb ötlet nem volt, mondjuk ennek az elméletnek ellentmod, hogy akkor miért kezdtek új saját gyárat építeni, viccből lehet. Vagy csak simán rájöttek, hogy az Intel féle stratégia mégsem akkora hülyeség.

[ Szerkesztve ]

The further a society drifts from truth, the more it will hate those that speak it. (George Orwell) [Work Machines: HP EliteBook, HP ProBook & Linux Mint 20 ; Entertainment: Apple Macbook AIR M1]

-

Abu85

HÁZIGAZDA

Igazából van az Intelnek Xeon Workstation vonala, csak nem olyan gyors, mint a Ryzen Threadripper PRO. A Zen 3-as verzió ellen pedig tök esélytelen lesz. De a termékskála létezik: [link]

Azért nincs erről annyira szó, mert a nagyobb OEM-ek a Ryzen Threadripper PRO-ra építenek. A Xeon Workstation sok cégnél nem is létezik, mert felesleges papíron tartani. Úgyis mindenki Threadrippert vesz ide.

[ Szerkesztve ]

Senki sem dől be a hivatalos szóvivőnek, de mindenki hisz egy meg nem nevezett forrásnak.

-

hallador

addikt

válasz

#32839680

#12

üzenetére

#32839680

#12

üzenetére

Igen erre gondoltam én is, tehát nincs alternatíva, ki is használja az AMD.

Igen tehát akkor nincs igazából alternatívája a AMD Ryzen Threadripper PRO-nak.

A lényegen nem változtat, hogy az AMD sem jobb az Intelnél, ha árazásról van szó, amit írtam, tartom, amint az AMD most jobb, de már nem is olcsóbb sőt. Ami nem probléma, csak ne állítsuk be úgy, mintha az AMD ne azt csinálná, amit az Intel csinált.[ Szerkesztve ]

The further a society drifts from truth, the more it will hate those that speak it. (George Orwell) [Work Machines: HP EliteBook, HP ProBook & Linux Mint 20 ; Entertainment: Apple Macbook AIR M1]

-

sutyerák007

senior tag

Persze, hogy azt csinálja amit az intel ők is a profitra mennek. Azt viszont nem szabad elfelejteni hogy nincsenek egy szinten. Közel sem tud annyit gyártani az amd (legalábbis ahogy én látom) mint amennyit el tudna adni. Kell a pénz hogy kevesebb kapacitással versenyben tudjanak maradni a kék óriás ellen.

[ Szerkesztve ]

-

hallador

addikt

válasz

#32839680

#15

üzenetére

#32839680

#15

üzenetére

Na várj már ez az én dumám. Amikor én írtam ezt azzal jöttetek, hogy a 64 mag lesz minden Workstationben a világon.

Szóval értem, hogy közben rájöttetek arra amit én fél éve írtam, de akkor most tulajdonképpen hogy is van ez?Bocs nekem az a szánalmas, hogy először azt írod, hogy verjük le a nagykeren utána azt, hogy romlott a Ft stb, stb. Ez mind igaz, elszállt az AMD ára vagy nem Igen ennyi. Szóval zárható is ez a vita....

Tudod azért jó veled vitázni, mert amikor valamit mondok, akkor mindig más verziókat hozol be, ahelyett, hogy ne félrebeszélnél.

Ebből nekem az jön le, hogy nincsenek érveid, hanem azzal jössz, amit én írtam le fél éve, akkor mondjuk én voltam hülye, akkor most ki a hülye.......

Igen ebben egyetértünk. Ezt írtam én is.

[ Szerkesztve ]

The further a society drifts from truth, the more it will hate those that speak it. (George Orwell) [Work Machines: HP EliteBook, HP ProBook & Linux Mint 20 ; Entertainment: Apple Macbook AIR M1]

-

hallador

addikt

válasz

#32839680

#18

üzenetére

#32839680

#18

üzenetére

... Ja ja

Megkértelek, hogy ne magyarázd meg az egyértelműt. Én ezeket fél éve leírtam, akkor hülyének néztetek, most meg ugyanazt szajkózzátok. Ennyi. Alternatív valóság mi?

[ Szerkesztve ]

The further a society drifts from truth, the more it will hate those that speak it. (George Orwell) [Work Machines: HP EliteBook, HP ProBook & Linux Mint 20 ; Entertainment: Apple Macbook AIR M1]

-

hallador

addikt

válasz

#32839680

#20

üzenetére

#32839680

#20

üzenetére

Igen az nem fél éve volt, tehát a VMware az én vagyok...

Nem az a baj, hogy most megpróbálod megmagyarázni, hanem az, hogy pont ugyanezt írtam le fél éve amit most Te. Csak akkor még hülye voltam ezért. Na akkor most minimum csendben kellene maradni ugye?[ Szerkesztve ]

The further a society drifts from truth, the more it will hate those that speak it. (George Orwell) [Work Machines: HP EliteBook, HP ProBook & Linux Mint 20 ; Entertainment: Apple Macbook AIR M1]

-

Abu85

HÁZIGAZDA

válasz

#32839680

#15

üzenetére

#32839680

#15

üzenetére

Ugyan az Intelnek és az AMD-nek is van úgymond "olcsó" alternatívája, de a valóság, hogy ezeket alig veszik. A Threadripper PRO sorozatból az eladások zömét a 64-magos adja, és a 32-magosra is nagy az igény, de 32 mag alatt már csak az eladások 5%-a van. Ezt a workstation vonalat tényleg azok veszik, akik 30+ magot akarnak.

Skálázni ettől még skáláz mindkét cég, mert a kis pénz is pénz, ráadásul nincs lényegi költsége a kevesebb magos megoldásoknak.

[ Szerkesztve ]

Senki sem dől be a hivatalos szóvivőnek, de mindenki hisz egy meg nem nevezett forrásnak.

-

hallador

addikt

Igen és ez nagy eséllyel igen kicsi réteg lesz ilyen árak mellett, ami a cikkben szerepel, mert ennyit nem fog senki kitermelni, ha a processzor viszi majd el a Workstation árának a 2/3-át.

The further a society drifts from truth, the more it will hate those that speak it. (George Orwell) [Work Machines: HP EliteBook, HP ProBook & Linux Mint 20 ; Entertainment: Apple Macbook AIR M1]

-

hallador

addikt

válasz

#32839680

#22

üzenetére

#32839680

#22

üzenetére

Figyelj nem fogok neked keresgetni fél éves hozzászólásokban. Keresd meg ha gondolod. És nem azért mert nem úgy van, ahogy én mondom, hanem azért mert hagy ne foglalkozzak a nyilvánvalóval.

Keresd meg magadnak. Sok helyen leírtam ezt.[ Szerkesztve ]

The further a society drifts from truth, the more it will hate those that speak it. (George Orwell) [Work Machines: HP EliteBook, HP ProBook & Linux Mint 20 ; Entertainment: Apple Macbook AIR M1]

-

hallador

addikt

válasz

#32839680

#26

üzenetére

#32839680

#26

üzenetére

Ugye megint behoztál valamit amiről most nincs szó.

Na látod ne magyarázz már kérlek félre! Köszi. Ha ennyi megy, akkor szerintem itt a vége.... Ne okoskodj, ha már nem sikerül csendben maradni, és ne utánozd a véleményem, ne kérdezz vissza tőlem arra amit fél éve leírtam, ehhez kell azért kell az arc...Akkor hülyének néztetetek, akkor most ki a hülye?The further a society drifts from truth, the more it will hate those that speak it. (George Orwell) [Work Machines: HP EliteBook, HP ProBook & Linux Mint 20 ; Entertainment: Apple Macbook AIR M1]

-

hallador

addikt

válasz

#32839680

#28

üzenetére

#32839680

#28

üzenetére

Te nem (akarod direkt érteni, mert hát ugye azért tudjuk, hogy akkor igazam volt, és ez most ki is derült, ma már Te is így gondolod, de akkor hülyének néztél emiatt.) érted nem ugyanaz!

Részemről Off a téma.

Persze persze tudod okos enged, Te meg csak írogass nyugodtan! Na szia...

[ Szerkesztve ]

The further a society drifts from truth, the more it will hate those that speak it. (George Orwell) [Work Machines: HP EliteBook, HP ProBook & Linux Mint 20 ; Entertainment: Apple Macbook AIR M1]

-

Sinesol

veterán

válasz

#32839680

#10

üzenetére

#32839680

#10

üzenetére

Csak azt felejted el, hogy az 5800x nem a teteje a kínálatnak, míg az 1800x az volt, csúcsot csúccsal érdemes összehasonlitani. Az 5800x közvetlen elődje a 3800x volt, ami 399 dolcsi volt. Plusz ugye az msrp is olyan, hogy az csak egy javasolt kiskereskedelmi ár, egyrészt nem sokat mond el arról, hogy az AMD mennyiért adja cuccot, plusz eltérhetnek tőle, nem jelent semmilyen kötelezettséget. Gyakorlatilag a listaárat jelöli az MSRP, az azonban relative ritkán az az összeg, amit kifizetsz. Általában lefelé térnek el tőle, de jelen sz.r helyzetben nyilván erősen felfelé, ebben pedig nyilván az is benne lehet, hogy nagy kereslet miatt az AMD is drágábban adja a cuccokat, ugyanis ha tetszik ha nem, az AMD is csak egy cég, ahol a profit az első.

[ Szerkesztve ]

-

Abu85

HÁZIGAZDA

Annyira nem pici réteg. Pont azért kap külön termékkategóriát, mert van erre reális igény. Ezeket a gépeket nagyrészt renderelni veszik, és úgy számolva már olcsóbb egy 64 magos Ryzen Threadripper PRO, mint venni négy külön gépet mondjuk Ryzen 9 5950X-szel. Produktivitásban ennek az előnye óriási, és számos cég szimplán visszaváltott GPU-s renderelésből CPU-sba, mert jobbak a lehetőségek (több TB rendszermemória), és ma már az erő is megvan a GPU-s teljesítményre a CPU-kban.

[ Szerkesztve ]

Senki sem dől be a hivatalos szóvivőnek, de mindenki hisz egy meg nem nevezett forrásnak.

-

GeryFlash

veterán

válasz

#32839680

#33

üzenetére

#32839680

#33

üzenetére

Sot nezhetne ugy, hogy amikor az AMD eloszor kijott 4 magos procival az mennyibe volt es most mennyi a 4 mag. Edesidtenem tiszteled mar meg a forumtarsadat hogy nem nezed ennyire hulyenek es arra valaszolsz amit mond, vagyis csucsot a csuccsal nezunk ossze, es hadd ne orvedenezzunk hogy igen valoban olcsobb a 16 mag mint 4 evvel korabban. Vannak teljesen jol egymasnak megfeleltetheto kategoriak es mindenhol azt latod hogy evrol evre jelentos MSRP novekedes volt az AMD-nel.

Hi, i'm new to APHEX TWIN, so i was wondering how much the IQ requirements was to enjoy his stuff. and understand all the underlying themes, because its really complex stuff. I have IQ of 119 but i heard that you need atleast 120 is it true?

-

keIdor

titán

Ugyanez volt a Core 2-k előtt is.

A legjobb az Athlon X2 4400+/4600+/4800+ volt a piacon, nagyon drágák is voltak ezek. Ez ugyanaz az AMD, ami régen is volt, kapitalista, profit orientált cég.A másik, amiért nem lesz sima Threadripper az az, hogy az X299 vonalat sem folytatják. Jön a Fishhawk Falls, de nem a régi HEDT vonal folytatása lesz, hanem fölé jön Xeon néven, ami a TR Pro ellenfele lesz és az árazás is hasonlóra várható. Core-X vonal halott, az AMD okosan ki is nyírta emiatt a sajátját.

¡GLORIA A LAS PLAGAS!

-

copass

veterán

"számos cég szimplán visszaváltott GPU-s renderelésből CPU-sba, mert jobbak a lehetőségek (több TB rendszermemória), és ma már az erő is megvan a GPU-s teljesítményre a CPU-kban."

ezt erősen kétlem, mert egyre több elérhető alkalmazás van ami GPU renderelést használ.

CPU render mindig lassabb lesz mint a GPU."amikor valaki baromságokat beszél, megszületik egy unikornis"

-

copass

veterán

válasz

#32839680

#35

üzenetére

#32839680

#35

üzenetére

hááát...nekem blender 3 demo fájl GPU 2:05 perc, CPU 2:37 perc...(50% képméret és csak 10 sample, 600 helyett)

statikus képnél is brutális a GPU előnye, de animációnál azért betyáros idők tudnak kijönni CPU rendernél...

ha cycles akkor gpu."amikor valaki baromságokat beszél, megszületik egy unikornis"

-

#52931072

törölt tag

válasz

GeryFlash

#36

üzenetére

GeryFlash

#36

üzenetére

Amikor az amd kijött az x2-vel, az intelnél volt minden ütőkártya, csak nyomott árral tudtak labdába rúgni. Most meg kőkeményen kasszírozni uk kell, mert a sárkány már ébredezik. Szerintem mindenki tudja, hogy az amd sem jótékonysági szervezet. Az intel meg történelme legjövedelmezőbb balfaszkodásán lesz túl lassan.

Azt meg tudjuk mi jön ezután, “felvásároljuk vagy dömping árral megfojtsuk a konkurenciát fejlesztés helyett?”[ Szerkesztve ]

-

copass

veterán

válasz

#32839680

#41

üzenetére

#32839680

#41

üzenetére

i9 11900K vs RTX 3060...

fél perc hátránya van, az még mindig óriási. nagyobb léptékben ezek órák/napok lesznek.

de ez csak a blenderre vonatkozik, az összes GPU-t használó proginál nem fognak vissza állni CPU-ra egy új és drága proci miatt...[ Szerkesztve ]

"amikor valaki baromságokat beszél, megszületik egy unikornis"

-

#16939776

törölt tag

Nem lehet az is a hátterében, hogy minden kategóriában a kiválóan/jól sikerült zen3 magokat használó termékek fogynak NAGYON, és így a kevésbé jól sikerült magok kisebb számban kerülnek értékesítésre mint amiben rendelkezésre állnának? Ergo nem tudják teljesen felhasználni, pénzé tenni a legyártott/megvásárolt waffereket?

-

copass

veterán

válasz

#32839680

#44

üzenetére

#32839680

#44

üzenetére

3060 12 GB VRAM-ba belefér egy 4K kép simán vagy ott van a quadro vonal p.: RTX 5000 16GB VRAM.

nagyobb lépték gpu renderfarm.

nagyon komoly támogatást kapnak az utóbbi években a GPU renderek mindenféle platformra. nem csak a vfx, de építészet. pl. archicad,sketchup,stb. mind-mind képes már adatot cserélni dinamikusan egy lumion, twimotion,unreal engine-el."amikor valaki baromságokat beszél, megszületik egy unikornis"

-

Abu85

HÁZIGAZDA

Igen, csak professzionális szinten egy GPU-val az "out of memory"-ig jutsz el, ami szart sem ér.

#47 copass : Nem a 4K-s képpel van bajuk, hanem a 200 GB-os modellekkel. Threadripper PRO mellé tudnak rakni 2 TB memóriát is, amibe ezek beleférnek.

#45 Duracellm... : Nem, aki Threadripper PRO procit vesz, az nem 12-16 magért veszi. Ekkora teljesítményt szerezhet a sima Ryzen PRO sorozatból is.

[ Szerkesztve ]

Senki sem dől be a hivatalos szóvivőnek, de mindenki hisz egy meg nem nevezett forrásnak.

-

copass

veterán

azért egy rtx szerverben szinte végtelen vram van és bármikor bővíthető...

eddig is megoldották ügyesen és hatékonyan hogy "out of memory" nélkül elkészüljön bármi...

az meg hogy már AAA filmekben,sorozatokban is egyre több teret nyer az UE virtuális stúdója még jobban a GPU felé tereli az ipart."amikor valaki baromságokat beszél, megszületik egy unikornis"

-

Abu85

HÁZIGAZDA

Nincs végtelen VRAM. Annyi van, amennyit egy GPU mellé pakolnak, vagy ha kell több VRAM, akkor két A6000-es összeköttetésével kaphatsz 96 GB-ot, de akkor az egyik GPU nem működik, és ugye a másik kártyán lévő 48 GB elérése lassabb.

A ProRendernek van egy úgynevezett "out of core" rendering képessége, amivel a VRAM-ba nem férő objektumokat el tudja helyezni a rendszermemóriában, és akkor el is megy értük a GPU, de ennek az a hátránya, hogy a rendszermemória elérése kurva lassú, tehát ugyan elméletben megszabadulsz a GPU-s "out of memory" hibaüzitől, csak közben annyit lassulsz, hogy egy Threadripperrel jobban jársz. Tehát igazából ez az "out of core" rendering ad is meg nem is. Leginkább arra jó, hogy hobbistaként ne vágj eret a sokadik "out of memory" hibaüzenet után, mivel ezzel a móddal ez nem lehetséges, de amint jelentősen meghaladod a VRAM határát, a lassulás elképesztően nagymértékű lesz, olyannyira nagy, hogy a GPU-s gyorsításból GPU-s lassítás lesz.

Az UE5 továbbra is raszterizálás, aminek van haszna a valós idejű leképezésben, de egy profi animációs stúdió továbbra is sokkal jobb minőséget akar magának, mentesítve magukat az UE5 leképezőjének fake hatásai alól.

A GPU-val azt lehet játszani, amit eddig. Szépen feldarabolod a jelenetedet apró szeletekre, hogy beférjen a VRAM-ba, és úgy megoldod a vizualizációt. Aztán, ha mindent jónak találsz, akkor megcsinálod a CPU-s rendert az összes adattal.

[ Szerkesztve ]

Senki sem dől be a hivatalos szóvivőnek, de mindenki hisz egy meg nem nevezett forrásnak.

-

thiclyoon

aktív tag

Nem tudom irónia-e, de kb. két éve ugyanennyikért néztem ilyen kategóriában ramokat

nevetséges, hogy már azt is eladják olcsónak, ami "olcsóbb", mint az évek alatt felemelt ár

nevetséges, hogy már azt is eladják olcsónak, ami "olcsóbb", mint az évek alatt felemelt ár  szóval nem hogy olcsóbbá vált volna az amúgy már lassan elöregedő technológia, de már annak is örülni kell, ha kb. ugyanannyiért meg lehet venni őket, mint korábban. Tudom, sok oka van az áremelkedésnek, de a végeredményt nézve ez a helyzet

szóval nem hogy olcsóbbá vált volna az amúgy már lassan elöregedő technológia, de már annak is örülni kell, ha kb. ugyanannyiért meg lehet venni őket, mint korábban. Tudom, sok oka van az áremelkedésnek, de a végeredményt nézve ez a helyzet -

copass

veterán

a hagyományos cpu render nagyon rossz irány, ezt igazolta az UE elterjedése a filmiparban és a blender cycle render sikere is.

prorender? "amd only"...ne viccelj már....pár éve eröltetik, kutya se használja igazából...

"A GPU-val azt lehet játszani, amit eddig. Szépen feldarabolod a jelenetedet apró szeletekre, hogy beférjen a VRAM-ba, és úgy megoldod a vizualizációt. Aztán, ha mindent jónak találsz, akkor megcsinálod a CPU-s rendert az összes adattal."

ebből a júzert szart se lát, mert a progi (már amelyik képes rá) darabolja annyi részre hogy elférjen a rendelkezésre álló vramban. mivel nem kell hogy valósidejű legyen, ezért az elérési idő teljesen másodlagos szempont. az csak a valósidőben számít, rendernél nem.

az hogy összerak x részt az meg picsafüst kategória...

de még így is sokkal gyorsabb mint a CPU render valaha is lesz."amikor valaki baromságokat beszél, megszületik egy unikornis"

-

Abu85

HÁZIGAZDA

válasz

#32839680

#56

üzenetére

#32839680

#56

üzenetére

Részletekre lehet használni, de másra nem igazán jó még.

#57 copass : Ha rossz irány lenne, akkor vásárolnának be a nagy cégek 64 magos Threadripperekből.

A ProRender egy gyártófüggetlen motor. A MAXON Cinema 4D, ACCA Software Edificius, Foundry Modo, InstaLOD Studio XL, SOLIDWORKS Visualize és Z-Emotion Z-Weave programokban van integrálva. Emellett van hivatalos Autodesk 3ds Max, Blender, SideFX Houdini, Autodesk Inventor, Autodesk Maya, PTC Creo és Unreal Engine plugin.

A usernek nem hozzák nyilvánosságra azokat a rendereket, amik a szétdarabolt elemekről készültek. Azok csak arra vannak, hogy vizualizálják, hogy mi lesz az adott felületen az eredmény. A user csak a CPU-val renderelt végeredményt látja egy filmnél.

[ Szerkesztve ]

Senki sem dől be a hivatalos szóvivőnek, de mindenki hisz egy meg nem nevezett forrásnak.

-

copass

veterán

válasz

#32839680

#56

üzenetére

#32839680

#56

üzenetére

Twinmotion most integrálta a path trace-t. érezhetően komolyabb GPU-t kíván, de renderidő is megnyúlt a pár másodpercről néhány percre. de hát cserébe sokkal jobb lett a minőség.

Mandalorian-ban led falakat használtak, egy igazán brutálisan nagyot. egyetlen hátránya van a ledfalnak, az pedig a moire. ezért látszódik úgy mintha életlen lenne.

én csak építészetre használom twinmotion-t és piszkosul felgyorsult a munkafolyamat.

kimarad az a rész hogy várni kell a renderre, arról nem is beszélve hogy azonnal látom a végeredményt és tudok azonnal módosítani."amikor valaki baromságokat beszél, megszületik egy unikornis"

-

copass

veterán

"Ha rossz irány lenne, akkor vásárolnának be a nagy cégek 64 magos Threadripperekből."

a cpu render rossz irány...de ez semmit se bizonyít.

"A usernek nem hozzák nyilvánosságra azokat a rendereket, amik a szétdarabolt elemekről készültek. A user csak a CPU-val renderelt végeredményt látja egy filmnél."

alapértelmezésben nem látod a köztes fázisokat egy rendernél. megkapod azt a képet amit beállítottál és kész.

ha akarod utómunkázni, akkor kinyered a különböző rétegeket belőle: z depth, AO, color,stb.

ha statikus akkor PS-ben összedobálod, ha animáció akkor meg nuke,fusion,after effects,stb.

de már ezeknek a számolása is GPU gyorsított, mert a CPU tetves lassú."amikor valaki baromságokat beszél, megszületik egy unikornis"

-

Abu85

HÁZIGAZDA

Az a gond, hogy ráálltál erre a CPU render rossz irányra, amit most írsz folyamatosan, de addig ez lényegtelen, amíg nem tudod megmondani azoknak a cégeknek, akik "tonnaszámra" veszik a 64 magos Threadrippert, hogy miért rossz.

A GPU alapvetően addig jó a rendereléshez, amíg beleférsz a memóriájába, illetve amíg a jelenet egyszerű. Amint kifutsz a memóriából jön az out-of-memory, míg ha egy picit is komplex a jelenet, akkor meg jön a jelentős hatékonyságvesztés, amitől már lazán le tud verni egy 64-magos Threadripper egy csúcs-GPU-t is. Egyszerűen azért, mert a teljesítmény konstans a jelenet komplexitása nem befolyásolja jelentősen. És a helyzet az, hogy professzionális szinten alig vannak szimpla jelenetek, tehát értik azt, hogy a GPU jó ezek alatt, de mit kezdjenek vele, amikor nem hobbi szinten foglalkoznak ezzel, hanem professzionálisan...

Aki hobbiból csinálja nyilván számoljon GPU-val, nekik kellően egyszerűek a jeleneteik, hogy a GPU-k erőteljes limitációiba ne fussanak bele. De mindenki más számára a CPU a gyorsabb.

[ Szerkesztve ]

Senki sem dől be a hivatalos szóvivőnek, de mindenki hisz egy meg nem nevezett forrásnak.

-

arn

félisten

Nincs min csodalkozni, amikor a mainstream 800 eur.

facebook.com/mylittleretrocomputerworld | youtube.com/mylittleretrocomputerworld | instagram.com/mylittleretrocomputerworld

-

copass

veterán

"tonnaszámra" ez blikk kategória...

amúgy a Mandalorian-ál mi kell professzionálisabb bizonyíték arra hogy a GPU jobb?

nagypályások rtx quadro,a6000 farmokat építenek/bérelnek...

de tessék: Unity Heretic , Irradation, The Matrix Awakens.

dolgoztál valaha is cpu/gpu renderrel?

cpu legnagyobb hátránya a munkafolyamat merevsége. leszámolod a képet, megvárod a rendert, módosítod, leszámolod újra. ehhez irgalmatlan sok idő és erőforrások kellenek.

gpu-nál kevesebb idő alatt végzel, mivel egyből látod a végeredményt. így jobb és több munkát tudsz megcsinálni, mivel kimarad az ellenőrzési fázis és a számolási idő.

hiába köpködik sokan hogy milyen felesleges az rtx is, de a fejlesztők meg tapsikolnak hogy nem kell "mókolni" a fényekkel. pl.: metro exodus enhanced edition.

ez a jövő, mit jövő. már a jelen.

szóval nekem aztán hajtogatod ez az out-of-memory bullshit-et reggelig..."amikor valaki baromságokat beszél, megszületik egy unikornis"

-

Abu85

HÁZIGAZDA

Jelen pillanatban nincs olyan alternatíva, ami képes helyettesíteni CPU-t. Hobbi vagy félprofesszionális szinten lehet bohóckodni GPU-val, de sem kellő memória nincs rajta, se kellően konstans teljesítmény nincs benne. És a konstans teljesítmény nagyon lényeges, mert az a GPU gyenge pontja. A komplexitás növelésével a CPU konstansan lassul, tehát egy adott CPU-val egy tízszer komplexebb jelenet nagyjából tízszer tovább tart. Egy GPU-ra ez nem igaz, ott a tízszer komplexebb jelenet százszor tovább tarthat. És ez professzionális szinten óriási probléma, mert amíg egy hobbi vagy félprofesszionális felhasználó elvan azzal a komplexitással, amiben a GPU teljesítménye nem zuhan erőteljesen be, addig professzionális szinten ez már nem jellemző.

Azt tudnod kell, hogy az AMD konkrétan azért csinálta a Threadripper sorozatot, mert amíg ez nem volt, addig a stúdiók vagy megvették a leggyorsabb mainstream asztali procit, vagy mentek szerverekre. Egyiket se szerették, mert mainstreamben nem volt teljesítmény, a szerverben pedig olyan dolgokat fizettek meg, amiket nem használtak. De más választásuk nem volt, muszáj volt szerverprocit vásárolniuk, ami abban az időben nagyrészt Xeon volt. Ebbe az idillbe szert bele az AMD a Threadripperrel. Felkínálta a szerverszintű teljesítményt ötödáron. És ez annyira bejött, hogy mindenki fejvesztve rohant Threadripperre, mert végre nem kellett kifizetniük a szerverprocik funkcióit, amiket nem is használtak. Azóta annyi változott, hogy gyakorlatilag az Intel eltűnt a HEDT-ről, így az AMD most már nem ötödáron adja a szerverszintű teljesítményt, hanem féláron. Még így is megéri a cégeknek, mert a felezett költség is előnyös számukra, de nyilván látszik, hogy az Intel itt már nem alternatíva, a GPU-k sose voltak azok, így az AMD arra a pontra áraz, ami számukra egy profitmaximalizálási pont.

Amiket felhoztál demók pont semmi sugárkövetést nem tartalmaznak. Szimpla raszterizációk. Ráadásul a The Matrix Awakens csak konzolra van. Nem véletlenül nem hozták még PC-re, ugyanis a jelenlegi kódnak 41 darab Zen 2 mag kell ahhoz, hogy működjön a valós idejű tartalomdekódolás. Nyilván az EPIC ezt meg tudja oldani, mert 64 magos Threadrippereken fejlesztenek, de rajtuk kívül annyira sok játékosnak nincs ilyen gépe. A konzolokon pedig erre dedikált részegység van, ami a PC-kből hiányzik. De ezeknek a demóknak a célja a valós idejű leképezés, és emiatt eléggé fake-ek, ami látszatra jól néz ki, de offline szinten abszolút nem lenne elég.

A DirectX és Vulkan Raytracing pedig megközelítőleg sem olyan komoly, mint a rendermotorokban alkalmazott megoldás. Lényegében csak effektekre jó, de mivel nincs az API-kban támogatás a dinamikus LOD-ra, így ott is extrém mértékben korlátozottan. Azért kell nagyítóval keresni a változásokat a játékokban az RT on és off között. Egyszerűen túl limitáltak a lehetőségek a jelenlegi hardverek és API-k miatt. Van olyan fejlesztő, aki elsőként szállt fel az RT-re, de már le is szállt róla, lásd DICE. Ennek az oka, hogy egyszerűen nem éri meg vesződni a jelenlegi, extrém korlátozott lehetőségekkel, mert a minőség alig javul. Ma ez arra jó, hogy a játékosok bekapcsolják, és azt mondják, hogy a "sebességzuhanáson kívül nem látnak semmit". Ez nyilván sokat változik majd a traversal shader megérkezésével, de addig a lehetőségek nagyon-nagyon limitáltak.

[ Szerkesztve ]

Senki sem dől be a hivatalos szóvivőnek, de mindenki hisz egy meg nem nevezett forrásnak.

-

copass

veterán

"dolgoztál valaha is cpu/gpu renderrel?"

erre válaszolj inkább emiatt a belemagyárázás helyett..."Azt tudnod kell, hogy az AMD konkrétan azért csinálta a Threadripper sorozatot, mert amíg ez nem volt, addig a stúdiók vagy megvették a leggyorsabb mainstream asztali procit, vagy mentek szerverekre."

jah persze, csakis ezért..."Ráadásul a The Matrix Awakens csak konzolra van. Nem véletlenül nem hozták még PC-re, ugyanis a jelenlegi kódnak 41 darab Zen 2 mag kell ahhoz, hogy működjön a valós idejű tartalomdekódolás. "

azért nem jött ki még PC-re mert ez egy konzolos UE5 erődemonstráció, nem a HW limit akadályozza meg benne. Epic nem szúrja tökön magát egy hw limites fejlesztéssel!

PC-n egyértelmű hogy jól fog kinézni, mert ott minden jobb. a bugos CP2077 is jobban fut és szebb is mint PS5-ön...

"Azért kell nagyítóval keresni a változásokat a játékokban az RT on és off között. "

azért nem látod a különbségeket, mert fingod sincs mit kell nézni..."Van olyan fejlesztő, aki elsőként szállt fel az RT-re, de már le is szállt róla, lásd DICE. Ennek az oka, hogy egyszerűen nem éri meg vesződni a jelenlegi, extrém korlátozott lehetőségekkel, mert a minőség alig javul"

csúsztatás, sokkal egyszerűbb a fejlesztés RT-re. nincs bakelés,fake light, reflection,stb.

beraksz egy egy napot/éjszaka a lámpákat, felanyagzod és dolgozik a hw...

pl: Metro Exodus Enhanced Edition"A DirectX és Vulkan Raytracing pedig megközelítőleg sem olyan komoly, mint a rendermotorokban alkalmazott megoldás."

lehet új lesz amit mondok: Vray már nagyon sok éve támogatja a GPU gyorsítást, GPU+CPU hibrid render,stb. tavasszal jött ki a Chaos Vantage-el, ami direkt RTX-re épül brutális teljesítménnyel.

igen, ez egy város...szóval ennyit a limitációkról és az amd cpu meneteléséről...

Brick Visual showcase vidi

"amikor valaki baromságokat beszél, megszületik egy unikornis"

-

copass

veterán

"Van olyan fejlesztő, aki elsőként szállt fel az RT-re, de már le is szállt róla, lásd DICE."

Battlefield 2042 RT támogatssal jött ki...

benézted, ez is..."amikor valaki baromságokat beszél, megszületik egy unikornis"

-

Abu85

HÁZIGAZDA

válasz

#32839680

#67

üzenetére

#32839680

#67

üzenetére

Sokat dobnának, ha lenne traversal shader, de mivel nincs, így nagyon memóriazabálók, ahol pedig nem eszik a memóriát, ott kevés előnyt adnak.

Lumenhez hasonló kamu GI korábban is volt. Ez nem újdonság, maximum az Unreal Engine-ben az.

A traversal shadert a gyorsulás miatt tervezi a Microsoft. Már bele van rakva a DXR roadmapbe: [link]

Ugye eleve az a probléma, hogy egy viszonylag nagy fixfunkciós egység csak 15-20%-ot hoz. Annak a helyére beépítesz 30%-kal több ALU-t, és ugyanott vagy teljesítményben. De ez leginkább azért van, mert az NV egy MIMD feldolgozót használ traversalra, ami extrém rossz hatékonyságú ilyen műveletek alatt. Az Imagination megoldása például bő 3x gyorsabb, mert nem MIMD motort használnak. A gond viszont ugyanúgy megvan nekik is. Hiába gyorsabb 3x, ha a fixfunckiós blokk miatt 200-300 MB helyett 2-3 GB VRAM kell az RT effektnek. Egyszerűen ennyire nincs hely, és még a sávszélpazarlás is viszi a teljesítményt. Tehát egyáltalán nem ússzuk meg a traversal shadert, csak új hardverek kellenek hozzá, meg úgy nyomni kell egy resetet az RT API-k oldalán is.

#69 copass : Dolgoztam már igen. De én hobbi szinten csinálom, nekem a GPU a jobb. Viszont nyilván be tudok tölteni olyan komplex jelenetet a Blenderbe, hogy a CPU gyorsabb legyen. Ez a GPU átka, inkonzisztens a teljesítménye.

Azért konzolos a The Matrix Awakens, mert alig van PC, ami futtatni tudja. Megvan maga a kód, működik, de 41 magot vesz el az EPIC fejlesztői gépén a tartalomkikódolás. Ha nincs ennyi magod szabadon csak erre, akkor akadni fog. Ezen majd a PC-s DirectStorage fog segíteni, csak az még nem érhető el publikus szinten. Viszont azzal a tartalomdekódolásnak elég 6 darab Zen 2 mag, és további 6 elég a többi feladatra. A konzolon ez azért működik, mert a Sony és a Microsoft dedikáltan fejlesztett erre a részfeladatra egy fixfunkciós hardvert. PC-n a feladatokat megosztja majd a CPU és a GPU, de már van kísérlet rá, hogy az IGP-t is be lehessen fogni a CPU tehermentesítésére.

Ne aggódj tudom mit kell nézni, csak az eredmény borzalmasan lehangoló.

Egy csomó rendermotor támogatja a CPU és GPU feldolgozást, a problémát nem ez jelenti, hanem a GPU-k limitjei. Ez látható a képen is, amit beraktál, ott iszonyatosan rossz a minőség. Ha mondjuk csinálsz egy animációs filmet professzionális szinten, akkor ezzel a minőséggel kiröhögnek.

#70 copass : A BF5 bevezette az RT reflectiont. Ezt kivették a BF2042-ből, és gyakorlatilag észrevehetetlen RTGI került a helyére, ami egyrészt egy sokkal kevésbé számításigényes effekt, másrészt igazából a teljesítménycsökkenésért cserébe nem ad semmi látható előnyt. Ellentétben az RT reflectionnel, aminek a BF5-ben csak az volt a baja, hogy kamurobbanásokkal baszták el az eredményét, de ezt könnyen lehetett volna orvosolni, ehhez képest kompletten kivették, mert nagyon VRAM-igényes volt. Hát így fejlődik manapság az RT, szépen visszaváltott a DICE erre: [link]

[ Szerkesztve ]

Senki sem dől be a hivatalos szóvivőnek, de mindenki hisz egy meg nem nevezett forrásnak.

-

NandoXXL

senior tag

válasz

thiclyoon

#54

üzenetére

thiclyoon

#54

üzenetére

Semmit nem ér most a forint, nézd meg az árfolyam változást. Inflációról nem is beszélve. Most akinek kell: még vehet memóriát jó áron, később jöttök sírni majd, úgy hogy szólva lett.

Nincs olyan hogy valami végtelenül olcsóbb lesz: drágul és/ vagy kivezetik... Nem értem: infláció van, forint gyengülés, chip hiány, 2 év eltelt (ennyi idő alatt elvileg a fizu is nő) ugyan az az ár olcsóbbnak számít.. Milyen sulit végeztetek?[ Szerkesztve ]

-

thiclyoon

aktív tag

"Milyen sulit végeztetek?"

"Tudom, sok oka van az áremelkedésnek, de a végeredményt nézve ez a helyzet"

Szóval megismételve: pontosan tudom, hogy több oka is van az áremelkedésnek, de te belinkelted a ramokat arra reagálva, hogy "ha valami, bármi, olcsó lenne! Na az lenne hír." Ez minden, csak nem olcsó (MOST, mert persze volt időszak, hogy olcsó(bb) volt). Akkor sem, ha 2022-ben még ennél is drágább lesz.

(Engem nem fogsz sírni látni, az utolsó wines gépemet felpimpeltem amennyire kellett (elég még jópár évig, főleg alap dolgokra (mivel már más használja)), a maceken meg nem tüntetik fel, hogy az alapkonfig árának mennyi része a ram költsége*. Így ez nem is érdekel már 1-2 éve )

)*Mielőtt direkt félreérti valaki: tudom, hogy az extraramot feltüntetik, ahogy nyilván költsége van a ramnak az alapkonfigban is. Csak mivel nincs ott, így az egész gépért kell fizetni, amin a ram árának változása minimális eltérést fog okozni, ha okoz.

[ Szerkesztve ]

-

Abu85

HÁZIGAZDA

válasz

#32839680

#72

üzenetére

#32839680

#72

üzenetére

A DirectStorage PC-s verziója elég sokban különbözik a konzolostól, tehát hatékonyságban nem fogja hozni az Xboxos szintet, a PS5-ös megoldást pedig pláne nem, de arra azért elég lesz, hogy ne legyen reménytelen lassú az alkalmazás PC-n. Ehhez a CPU-t és a GPU-t használja. A rendszermemóriába továbbra is a CPU kódol ki, míg a GPU VRAM-jába a GPU. Sebességben ez biztosan hátrányos az Xboxhoz viszonyítva, de PC-n sokkal több memória van, tehát több adat tölthető be. Továbbá fontos, hogy PC-n még mindig ott a lehetőség több tárhelyet használni. Csak konzolon nagy gond az adatmennyiség helyfoglalása, PC-n simán ki lehet adni kódolatlan tartalmat is, és akkor a játék 300-400 GB-nyi helyre fog települni. Minél több tárhelyet használsz, annál kevesebb kódolt adatot szállítasz, és annál kevesebbszer kell a tartalmat kikódolni. Eleinte valószínű, hogy csak a tartalom egy részét kódolják majd le a PC-s portokban, így az adott játék helyigénye PC-n jóval nagyobb lesz, de ezt egyszerű megoldani új SSD-kkel. Csak konzolon követelmény, hogy ne legyen a játék 500 GB-nál nagyobb.

Ez nem csak a kódolásról és dekódolásról szól, hanem a mintavételezésről is. Komplexebb ez annál, hogy szimplán egy compute shaderrel megoldják a fejlesztők. Kell hozzá egy új IO API, egy új menedzsment az OS-re, stb. Bár utóbbi nem kritikus, de hasznos tud lenni. Az IO API fejlesztése viszont minimum szükséges. Onnan már lehet írni compute shader a dekódolásra. Alapvetően a Microsoft dekódoló kódja sem lesz más, mint egy erőteljesen optimalizált compute shader. De a kulcs az IO API modernizálása, anélkül ez nem megy, és a DirectStorage frissítésére a Microsoft hoz is egy új IO API-t a Windows 10-be és 11-be. A Windows 10-ből csak az új menedzsment hiányzik majd, ami a 11-nek sebességelőnyt ad, de nem teszi futtathatatlanná Windows 10 alatt a játékokat, csak valamivel lassabbak lesznek. A hardver kihasználása már döntés kérdése. Nyilván a CPU az optimális a rendszermemóriához és a GPU a VRAM-hoz, de már most vannak olyan tesztek, hogy az IGP is ki tudja kódolni a tartalmat a CPU helyett a rendszermemóriába, és akkor nem kell erre CPU-magokat használni. A lehetőségek innentől eléggé tágak.

Most van ebből probléma csak, hogy nincs kellően jó IO API, így jelenleg csak a sok RAM-ban és a sok magban lehet bízni, de tavasszal ez majd megváltozik.

[ Szerkesztve ]

Senki sem dől be a hivatalos szóvivőnek, de mindenki hisz egy meg nem nevezett forrásnak.

-

copass

veterán

"Lumenhez hasonló kamu GI korábban is volt."

valószínüleg azért szólt ekkorát az engine, mert kami GI...perszehogy.

a fake GI látszik hogy az fake, mert randa mint a bűn.

"hobbi"

a hobbi nem munka, tehát nem dolgoztál egy büdös percet sem vele...

20+ éve csinálok látványterveket főállásban. tudom hogy mi lassú és mi gyors."Viszont nyilván be tudok tölteni olyan komplex jelenetet a Blenderbe, hogy a CPU gyorsabb legyen. Ez a GPU átka, inkonzisztens a teljesítménye."

hülyeség...cpu sose lesz gyorsabb, pláne egy komplex jelenetnél. hogymár..."Ez látható a képen is, amit beraktál, ott iszonyatosan rossz a minőség. Ha mondjuk csinálsz egy animációs filmet professzionális szinten, akkor ezzel a minőséggel kiröhögnek."

honlapról leszedett kép...ne legyél már ennyire nevetséges...

Brick nemzetközileg elismert és nagyon magas szintet képvisel. Vray,3dsmax-al működnek együtt rendszeresen, egy tonna díjat nyertek...jah és magyarok. felettük csak a Digic van, ők is piszkálgatták az rtxeket"amikor valaki baromságokat beszél, megszületik egy unikornis"

-

Abu85

HÁZIGAZDA

A Lumen leginkább azért szólt akkorát, mert az UE-ben eddig hasonló GI megoldás nem volt. De minőségileg a raszterizálást alkalmazó megoldások közül még mindig a CryEngine-féle SVOTI viszi a prímet.

A legjobb megoldás alapvetően egy RT-féle GI, de ez kurva lassú és dinamikus LOD nélkül marhára memóriapazarló, így ma még mindig trükközünk. Az SVOTI abból a szempontból előnyösebb, mint a Lumen, hogy alkalmaznak rajta egy olyan LOD határt, amin belül mindent háromszögekre számolnak, hogy precíz legyen, és ezen a határon túl jön a voxeles trükközés. Persze ez nagyrészt annak köszönhető, hogy a Crytek már fél évtizede bevezette ezt, tehát bő 5-6 évvel több fejlesztés van a saját implementációjukban, mint a Lumenben, így természetes, hogy a Lumen nem ugorja rögtön át az SVOTI-t, de hasra esni nem kell tőle csak azért, mert korábban az UE-ben nem volt értékelhető GI, és most lett.Viszont nem animációs sorozatokat készítesz, ahol megint tudják a cégek, hogy mi a lassú és mi a gyors. Sőt azt is tudják, hogy mekkora memóriát foglal le a jelenet. Ezért mondtam, hogy a saját kis világod vetíted ki a piacra, és elképzelhetetlennek tartod, hogy vannak olyan piaci szereplők, akik 200-300 GB-os jelenetekkel dolgoznak. Egy ilyen jelenet nálad is csak CPU-val működne.

A komplex jelenet abból a szempontból probléma, hogy a GPU-k egyfajta SIMT rendszerek. Amikor kapnak egy shadert, akkor annak a shadernek van egy regiszternyomása. A rendermotorokben azért nem ritkák azok a fajta übershaderek, amelyek olyan jelentős regiszternyomással dolgoznak, hogy egy GPU-n belül a multiprocesszor nem tud egy szálnál többet futtatni párhuzamosan. Ezzel bukod is a GPU sebességét, mert nincs elég szál arra, hogy átlapold a memóriakésleltetést. Ez a probléma a CPU-knál azért nem gond, mert azok eleve egy szálra optimalizált magok, és kurva sok cache-t használnak egy szálra levetítve. A GPU-k addig a pontig gyorsak és hatékonyak, amíg a regiszternyomás az optimális wave-határon tartja a működést, amint egy olyan shader jön, hogy szuboptimálissá válik a konkurens wave-ek alacsony száma, rögtön jelentősen veszít a hardver a sebességéből, mert abban rejlik a GPU ereje, hogy párhuzamosan dolgozik, de ha egy szálnak annyi regiszterre van szüksége, amennyi összesen van a multiprocesszorban, akkor nem nem tud a GPU második szálat indítani, vagyis az adatpárhuzamos végrehajtásnak lőttek. Emiatt tudják a CPU-k lehagyni komplex jelenetekben, komplex shaderekkel a GPU-kat.

[ Szerkesztve ]

Senki sem dől be a hivatalos szóvivőnek, de mindenki hisz egy meg nem nevezett forrásnak.

-

copass

veterán

"A legjobb megoldás alapvetően egy RT-féle GI, de ez kurva lassú és dinamikus LOD nélkül marhára memóriapazarló"

metro exodus enhanced edition, nem lassú egy 3060-on sem fullban...az idő nagyon fontos tényező ebben a szektorban. minden tegnapra kell, folyamatos változtatások mellett.

az alapok nem változnak:minden agyon van optimalizálva. modell, texturák, fények,render,stb. ahol lehet "csalnak", pl.: matte paint.

az a lényeg hogy jól nézzen ki. leszarják hogy mivel érik el azt, ha kell írnak saját tool-okat, szoftvert váltanak,stb. ha vmit gyorsabban le lehet leszámolni, akkor vesznek/bérelnek/építenek amit kell. ha gpu farmmal csak 1 nap egy jelenet és nem 1 hét, akkor azzal csinálják.

pl: deadpool nyitó jelenetének a previz-ét már 5 éve gpu-val számoltatták le, az idő rövidsége miatt.

"vannak olyan piaci szereplők, akik 200-300 GB-os jelenetekkel dolgoznak."

"Nem a 4K-s képpel van bajuk, hanem a 200 GB-os modellekkel."

most akkor melyik? ez a 200-300 GB vmi joker, amit be lehet húzni?!

mert egyik sem igaz. ekkora modell nincs mert használhatatlan, egy jelenet több TB is lehet akár. de egyszerre sose használják...egyrészt mert csak azt dolgozzák ki részeletesen ami közel van a kamerához, a többi lowpoly lesz. másrészt proxyt-kat használnak a nagyfelbontású modelleknél, ami szerkesztéskor egy lowpoly elemet tesz be. pl. növényzetnélsenki nem vonja kétségbe azt hogy a cpu-nak mik az előnyei, de egyre jobban elterjedt a gpu profik között is. ennek az az oka hogy sokkal rugalmasabb a folyamat és azonnali visszajelzésed van a végeredményről. szinte eltűnik az a fogalom hogy "renderelési idő", mert azonnal látod a végeredményt és másodpercek alatt kész a kép/animáció.

"amikor valaki baromságokat beszél, megszületik egy unikornis"

-

Abu85

HÁZIGAZDA

Abban a játékban 3 virtuális méterig számolnak sugárkövetést. Az lenne a csoda, hogy ilyen extrém korlátozott működés mellett lassú lenne. Csak ugye ennyi a jó minőséghez nem igazán elég, ezért alkalmaz más módszert például az Unreal Engine 5 vagy a CryEngine 5, vagy a Frostbite, stb. Ők is szívesebben írnának egy RTGI-t, ami sokkal egyszerűbb, csak a jelenlegi API-kkal vagy rossz minőségű lesz (lásd Metro), vagy memóriazabáló.

Persze, hogyne... azért vesz ez a szektor 64 magos Threadrippereket. Fontos, hogy hamar kész legyen.

Mindkettő. 200-300 GB azért lényeges, mert manapság nagyjából akkora egy modell, amivel dolgozik egy professzionális stúdió. És nyilván azért vesznek 2 TB-ot a Threadripper mellé, mert bizony több ilyen modellel kell is a 2 TB memória. Ezért írtam, hogy attól mert te még sosem dolgoztál ilyennel, ez még létezik.

A csalással az a gond, hogy időbe kerül. Azzal, hogy kihozol egy sculptingolt modellt, majd elkezded optimalizálni, lementeni az adatokat normal mapba, csökkenteni a poligonszámot, a modell méretét, stb időt veszítesz. Ez ugyanis mind emberi munka. Mindezzel együtt minőséget is veszítesz, ami esetenként elfogadható, de néha nem az. Akiknek van pénze rá, azok vesznek 2 TB RAM-ot és egy bivaly CPU-t, aztán mehet a móka a sculptingolt modellel. De az is CPU-t vesz, aki tudja a GPU-k limitjeit. Ezekkel ugyanis fentebb írtam, hogy addig nyersz sebességet, amíg olyan shaderek futnak, amiket tudsz párhuzamosan számolni. Amint soros feldolgozásra kényszerülsz a GPU-n, rögtön sokkal jobb lesz a CPU. És hát ezeket a limiteket egy mai GPU-n nem nehéz elérni, mert az a nagy büdös helyzet, hogy mindegyik GPU statikus erőforrás-allokációt használ. Ez majd akkor fog sokat változni, ha valaki áttér a dinamikus erőforrás-allokációra, csak az nagyon sok tranyót igényel.

A piac ettől még elvan a GPU-kkal, a csóróknak nincs más választása, de akinek van pénze rá, az simán veszi a CPU-kat, mert sok memóriát lehet venni mellé, és konstans a teljesítménye.

[ Szerkesztve ]

Senki sem dől be a hivatalos szóvivőnek, de mindenki hisz egy meg nem nevezett forrásnak.

-

copass

veterán

"3 virtuális méterig számolnak sugárkövetést."

kötekedés...pont elég arra hogy krvajólnézzenki."Mindkettő. 200-300 GB azért lényeges, mert manapság nagyjából akkora egy modell, amivel dolgozik egy professzionális stúdió."

tapasztalatból hallottam kategória...nyomokban sincs köze a valósághoz..."A csalással az a gond, hogy időbe kerül. Azzal, hogy kihozol egy sculptingolt modellt, majd elkezded optimalizálni, lementeni az adatokat normal mapba, csökkenteni a poligonszámot, a modell méretét, stb időt veszítesz."

hogymi?! mi ez az egetverő baromság?!

mi ez az egetverő baromság?!

azért van ez így kitalálva mert kezelhetetlen egy ilyen részletességű modell.

mindegy hogy milyen krvajócsilliómemóriás procit teszel alá, ha nem tudod megmozgatni valósidőben minimum 25 fps-el...márpedig ez a lényeg, nem az hogy belefér a ramba...industry standard workflow: modelling, sculpting, retopology, texturing (normal, height map), rigging és lehet animálni.

soha, de soha nem használják az eredeti sculpted modellt animálásra, nem hogy telekúrni velük egy egész scene-t..."aztán mehet a móka a sculptingolt modellel."

diavetítés...

ajánlom figyelmedbe a pixomondo makingofgameofthrone sorozatait,star trek discovery is az UE virtual szettjét használja...nem tudsz te semmit, csak kiabálsz a pálya széléről...

[ Szerkesztve ]

"amikor valaki baromságokat beszél, megszületik egy unikornis"

-

Abu85

HÁZIGAZDA

Ha elég lenne arra, hogy jól nézzen ki, akkor a top motorok is ilyet használnának, de látható módon egyik sem használ ilyet. Az UE5 is másfele megy, a Frostbite, a CryEngine, gyakorlatilag mindenki. Szóval, ha annyira jó az RTGI, akkor miért is nem használják az iparág top motorjai?

Mármint a saját tapasztalatodból, amit kivetítesz a teljes piacra, pedig maximum az 1%-ára illik rá.

Csak kezelhetetlennek hiszed, de pont az a lényeg, hogy simán kezelhető, csak elég memória és mag kell hozzá.

Ugyanez a lényege az Unreal Engine 5-nek, hogy az általad felvázolt "industry standard workflow"-nak a felét kidobhasd, mert megcsinálja maga a motor. Ezzel az Unreal Engine 5-tel offline workflow szintjén dolgozhatsz, csak real time. Persze ehhez kell is egy erős gép, például PS5 és XSX.

Vártam mikor megy át az egész személyeskedésbe. Nem vagyok ennek a híve, de ha gondolod, akkor csinálhatod, viszont olvasd vissza, amiket írtunk, és technikai magyarázatokat csak én hoztam, te pedig nem fogadod el, hogy a piacnak szüksége van a sok memóriára és a konstans teljesítményre, amit a GPU-tól nem kapnak meg.[ Szerkesztve ]

Senki sem dől be a hivatalos szóvivőnek, de mindenki hisz egy meg nem nevezett forrásnak.

-

copass

veterán

válasz

#32839680

#82

üzenetére

#32839680

#82

üzenetére

nanite csak statikus mesh-nél működik...animáció kuka innentől kezdve.

"Az egész demo, a fika kis barlanggal 100GB. "

erről beszélek, hogy egy teljes scene telepakolva objectekkel mekkora lesz? nem 1-2TB az tuti.

"Másrészt meg nem értem hogy hogy jön a realtime grafika, meg az animációnál használt sculptingolt modell ide. Képkockánként kirenderelt animációs filmnél kit érdekel hogy nem realtime?"

nem a grafikáról beszélek, hanem a workflowról.

abu azt erőlteti hogy 2TB rammal már lehet majd sculted modellekkel is dolgozni...

erre mondtam hogy animációnál ez megdől.

szerkesztéskor hogy animálsz ha szaggat a viewport? persze lehet wireframe box-okat bekapcsolni, de az elég '82 lenne...

ezért használják a retopológiát. amikor highres modellből, csinálnak egy alacsonyabb poligonszámú kezelhető modellt. amit már lehet normálisan riggelni. a riggeléshez hozzátartozik hogy minden felületet hozzá kell rendelni egy adott csonthoz. ezeket a csontokat lehet animálni.

pl: grizzly szépen csontozva,izmokkalépítészetnél statikus modellek vannak, semmi nem mozog. csak azt mutatják aminek muszáj látszódnia, minden mást kipucolnak belőle. normal,height map,textura. így tudnak egy egész várost is berakni akár. pl: avengers new york egy szakaszát cakkpakk megcsinálta.

szépen látszik hogy csak a közeli dolgok vannak kidolgozva, a többi már egyszerű síkokból áll. játékban automatikus a LOD, ha közel mész akkor a részletes modellt látod, ha távol akkor az egyszerűsítettet.

bármivel lehet épületet modellezni, de CAD tervet csak építész progival tudsz készíteni. ez a BIM. az igazi mélyvíz, amikor minden elemnek tárolva van a tulajdonsága, amit pl. egy költségvetés készítő progival lehet felhasználni..."amikor valaki baromságokat beszél, megszületik egy unikornis"

-

Abu85

HÁZIGAZDA

Akinek nem elég a 2 TB, elmegy EPYC-re, ott 4 TB a limit, de már sokan várják a következő EPYC-et, ahol 12 TB lesz. Az egy komoly technológiai ugrást képvisel majd. De ez nem éppen a piac nagy részének a játéktere. Akinek esetleg kell renderre szabott rendszer, de nincs pénze rá, az vehet gépidőt az AMD-től. Az EPYC óta van Hollywoodban és Londonban az AMD-nek direkten stúdiója, ahol csúcskonfigot lehet venni ideiglenesen, renderre. Ezzel nem kell kifizetni a hardvert magát, hanem elég bérelni azt. Eléggé sokan használják, mert a hollywoodi géppark folyamatosan bővül, hiszen egyszerűbb és kisebb kockázat a stúdióknak bérelni a gépet, mint építeni maguknak.

[ Szerkesztve ]

Senki sem dől be a hivatalos szóvivőnek, de mindenki hisz egy meg nem nevezett forrásnak.

-

copass

veterán

"Csak kezelhetetlennek hiszed, de pont az a lényeg, hogy simán kezelhető, csak elég memória és mag kell hozzá. Ugyanez a lényege az Unreal Engine 5-nek, hogy az általad felvázolt "industry standard workflow"-nak a felét kidobhasd, mert megcsinálja maga a motor."

ha egyszer is csináltál volna egy nagyobb scene-t highres modellekből, akkor tudnád hogy miért nincs létjogusultsága a highres modelleknek. ezért kell optimalizálni úgy ahogy.

ez nem faszméretegésről szól hogy én milyen részletes modellt tudok betölteni, hanem a használhatóságról. nagy különbség.mivel nincs semmilyen gyakorlati tapasztalatod a témában, ezért szakzsargonnal és elméletekkel operálsz. hiába hoztam fel több példát is, ugyanazt fújod...

egyre több nagyköltségvetésű sorozat készül (mandalorian,startrekdiscovery)

az UE ezért nagy dolog a GPU gyorsítással, mivel kimarad az eddigi időigényes módszer:

felvétel green screen előtt, render,kompozit,stb.

filmgyártás, építészet nem 1%...[ Szerkesztve ]

"amikor valaki baromságokat beszél, megszületik egy unikornis"

-

Abu85

HÁZIGAZDA

Jó, volt róla rossz tapasztalatod, de ez egyéni tényező, az iparágnak még szüksége van a magas minőségre. Értjük, hogy neked nem kell. Semmi baj nincs ezzel, de az iparágra felesleges kivetíteni. Ha erre tényleg nem lenne szükség, akkor a Lenovo nem fizetett volna több tízmillió dollárt az AMD-nek azért, hogy csak ők árulhassanak Threadripper Pro munkaállomásokat fél évig. Le is rabolták a célzott szegmens nagy részét vele...

Ha valamit elméletben sem tudsz megmagyarázni, az a gyakorlatban sem fog működni.

[ Szerkesztve ]

Senki sem dől be a hivatalos szóvivőnek, de mindenki hisz egy meg nem nevezett forrásnak.

-

copass

veterán

"Jó, volt róla rossz tapasztalatod, de ez egyéni tényező, az iparágnak még szüksége van a magas minőségre. Értjük, hogy neked nem kell. Semmi baj nincs ezzel, de az iparágra felesleges kivetíteni."

csak előhúztad a szokásos "hamárnemtudoktényeketközölniakkorjárassukle" kártyát...

arról az iparágról beszélsz aminek még a munkafolyamatát se ismered rendesen...

ez nem rólam szól. ezt így kell csinálni. minden szinten.mert ez működik

ezt tanulják, erre épül az egész iparág évtizedek óta.

ha kijön új fejlesztés, akkor nagyon jónak kell lennie hogy beépítsék.

abban a tévhitben élsz, hogy erős gép = minőségi munka...

az csak egy eszköz, ha nincs mögötte megfelelő tudás kitörölheted a segged a 2TB ramoddal. mert nem fog jól kinézni a sculpted animációd és nem érted hogy miért, mert nincs meg a tudásod hozzá..."Ha erre tényleg nem lenne szükség, akkor a Lenovo nem fizetett volna több tízmillió dollárt az AMD-nek azért, hogy csak ők árulhassanak Threadripper Pro munkaállomásokat fél évig. Le is rabolták a célzott szegmens nagy részét vele..."

blikk..."Ha valamit elméletben sem tudsz megmagyarázni, az a gyakorlatban sem fog működni. "

egyetlen érvemhez se tudtál normálisan válaszolni. mindig az lett a vége hogy hogy amd Threadripper Pro = magas minőség..."amikor valaki baromságokat beszél, megszületik egy unikornis"

-

Abu85

HÁZIGAZDA

Bátorkodom megjegyezni, hogy ebből a vitából én voltam az egyetlen fél, aki leírta, hogy mi a gond a GPU-val. Arra nem válaszoltál. Most tegyük félre a nyilvánvaló limitet, mint a memória. Mit kezdesz a GPU-val, ha egy olyan übershadert kell használnod a renderhez, aminek a statikus regiszterallokációja magas? Mondjuk 30 kB, ami egyáltalán nem ritka animációs filmeknél. Ilyenkor a GPU adatpárhuzamos végrehajtása sorossá változik, mert 30 kB-os regiszternyomás során az elméletben futtatható 10-30 wave helyett futhat egyetlen egy, azaz 1! Mit csinálsz ilyenkor a GPU-ddal, azon kívül, hogy elmész a boltba és veszel egy 64 magos Threadrippert, mert az egy CPU, és pont az ilyen komplex feladatokra ideális, amit éppen futtatni akarsz.

A GPU az nem varázslat. Vannak igen komoly limitjei, amik szimpla minőség mellett nem jönnek ki, mert szépen tudod adagolni neki a konkurens wave-eket, de amint nem tudsz adni neki ilyet, rögtön összeomlik a teljesítménye, úgy az ezred részére.

[ Szerkesztve ]

Senki sem dől be a hivatalos szóvivőnek, de mindenki hisz egy meg nem nevezett forrásnak.

-

copass

veterán

mindenre válaszoltam, csak nem veszed figyelembe...

mert ha olyan "óriási" lenne ez a "probléma", akkor senki se használná a gpu-t munkára nagy léptékben..quadro széria nem létezne, rtx se, pláne szerverekbe, egx platform kuka,stb.

"Mit kezdesz a GPU-val, ha egy olyan übershadert kell használnod a renderhez, aminek a statikus regiszterallokációja magas?"

sok itt a "ha"...minden shadert optimalizálni kell a rendelkezésre álló erőforrásokra, ezért nem létezik az a fogalom hogy "ezt kell használnom". ha lassú, akkor a shader szarul van megírva.

írnak sajátot ami megfelelő minőséget és teljesítményt nyújt. nem semmiért van egy kóder csapat a háttérben ebben az iparágban. lefejlesztenek mindent házon belül, amire szükségük van.nem ismered a modellezési módszereket, "magas minőség"-et se tudom hogy mi az neked (Bricket leszarozni khm okkéé...).

én csak azt látom hogy Amd Threadripper Pro lesz a vége mindig..."amikor valaki baromságokat beszél, megszületik egy unikornis"

-

Abu85

HÁZIGAZDA

Azért használnak GPU-t is, mert vannak szimpla jelenetek, amelyek nem dolgoznak komplex shaderekkel, és nem foglalnak sok memóriát. Ezekre jó a GPU is, sőt, jobb egy CPU-nál. A CPU akkor kell, ha a jelenet komplex, mert azokkal egy GPU nem birkózik meg.

Senki sem dől be a hivatalos szóvivőnek, de mindenki hisz egy meg nem nevezett forrásnak.

Új hozzászólás Aktív témák

ph Csak PRO verzió készül a Zen 3-as magra építve, és ezer dollár alatt még a legkisebb modellt sem lehet majd megszerezni.

Állásajánlatok

Cég: Ozeki Kft.

Város: Debrecen

nevetséges, hogy már azt is eladják olcsónak, ami "olcsóbb", mint az évek alatt felemelt ár

nevetséges, hogy már azt is eladják olcsónak, ami "olcsóbb", mint az évek alatt felemelt ár

)

) mi ez az egetverő baromság?!

mi ez az egetverő baromság?!