A háttér

A részecskék ütközései mikrométer léptékű helyre koncentrálódnak, ennek fényében különösen lenyűgöző az az ötemeletes építmény, amelynek minden eleme arra hivatott, hogy az ütközés során és után lejátszódó eseményeket érzékelje, és ezeket az információkat továbbítsa – a fizika, a gépészet, az elektronika, az informatika és még ki tudja, hány szakterület tökéletes szimbiózisa. Ahogy a többi kísérletnél, úgy az ATLAS esetében is több különböző réteget (szubdetektorokat) vonnak az ütközés helye köré; mindegyik réteg másféle – önmagukban is bonyolult – szenzorokból áll, melyek különféle részecskéket, illetve azok eltérő jellemzőit vizsgálják.

A nagy és nehéz alkatrészek emelése veszélyes művelet. A képen a CMS helyszíne látható – (c) CERN

A CERN vezérlőterme – (c) CERN

A kísérletek során rengeteg adat keletkezik, a szubdetektorok másodpercenként 300 ezer megabájt információt termelnek. Nyilvánvaló, hogy ekkora adattömeg feldolgozására nincs lehetőség, de szükség sem, ezért az adatfolyamokat nagy teljesítményű számítógépekkel erősen megszűrik. Az előzetes kalkulációk szerint, ami feldolgozandó adatként marad, az protonok ütköztetésekor átlagosan 50 megabájt az LHCb-től, 100 megabájt az ALICE-től, 225 megabájt a CMS-től és 320 megabájt az ATLAS-tól – másodpercenként. (Megjegyezzük, a nehézion-kísérletekben az ALICE 1,25 GB/s adatot zúdít rá a hálózatra, így ezek külön előkészítést igényelnek.) Összességében tehát másodpercenként 100–1000 megabájtnyi adat kezelésére kell tervezni a rendszert, melynek csupán a rögzítése sem kis feladat, nem beszélve az ezek kiértékelését végző szoftverek futtatásáról.

Tárhelyből és számítási kapacitásból sosem elég – (c) CERN

A megoldást a hálózat jelenti, pontosabban a hálózatba kötött számítógépek sokasága, az elosztott számítást végző grid. A megszűrt nyers adatok a detektoroktól 10 Gbps sebességű kapcsolatokon keresztül jutnak el a CERN számítóközpontjába. Itt automatizált szalagkönyvtárakban rögzítik őket, közben pedig a helyi szerverfarmon átesnek egy előfeldolgozáson is. Az itteni kapacitások azonban messze nem elegendők az adatok kiértékelésére, ezért a CERN-től tizenegy kiemelt központ kapja meg az adatokat. A nemzetközi hálózat első körében lévő központok közreműködnek az adatok tárolásában és analízisében, illetve rendelkezésre bocsátják azokat a második körben lévő, több mint száz központnak, ahol a fizikusok saját szoftvereiket futtathatják vagy szimulációt végeznek. A CERN és a felső szint dedikált 10 Gbps-os kapcsolatokon keresztül érintkezik, míg az alsóbb szintek kommunikációját többnyire általános célú kutatóhálózatokon, például a GÉANT 2-n keresztül biztosítják.

Nagy teljesítményű szerverek és az adatközpont hálózati csatlakozási pontja – (c) CERN

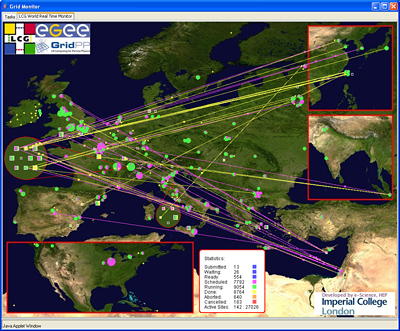

Természetesen nem puszta adatátvitelről van szó, a feladatok ésszerű felosztásáról és a rendelkezésre álló kapacitások optimális kihasználásáról az LHC Computing Grid (LCG) gondoskodik. Ez a rendszer részben már meglévő infrastruktúrára támaszkodik; az Open Science Grid főként Amerikában, az Enabling Grids for E-science (EGEE) pedig Európán kívül Észak-Amerikában, Ázsiában és Ausztráliában rendelkezik erőforrásokkal. A kutatók úgy számolnak, hogy évente 10–15 petabájtnyi hosszabb távon tárolandó adat keletkezik, és persze ennek a mennyiségnek a többszöröse áramlik át a mintegy 35 országot magában foglaló hálózaton. Az LCG-t egyébként úgy alakították ki, hogy a CERN-ben folyó részecskefizikai kísérleteken kívül más területeken (tudományos, műszaki, ipari alkalmazásokban) is fel lehessen használni.

Áttekintés az LCG által kiosztott feladatokról – (c) CERN

A nagy hadronütköztetőhöz kapcsolódó infrastruktúra fontos részei kötődnek a HP-hez, amely az IBM, az Intel, az Oracle és az Enterasys mellett a CERN fő informatikai támogatója. A vállalat szerverekkel és hálózati berendezésekkel segíti az elképesztő adatmennyiséget kezelő rendszer kiépítését. A helyi adatközpont az utóbbi két évben jelentős átépítésen esett át, és bővítése még ma is zajlik. A szerverek között vannak Itanium 2 processzorra alapozók, a fürtözött rendszer nagy része azonban Xeon processzoros gépekből épül fel, melyekből eddig 4000-et telepítettek, de folyamatosan 8000-re emelik számukat. A ProCurve hálózati eszközöket több területen is felhasználják: a kísérletek helyszínein, a szervereket és merevlemezes, illetve szalagos tárolórendszereket összekötő adatközponti hálózatban, továbbá a kutatók és a kiszolgáló személyzet által használt hálózatban. A 650 darab 3400cl switchen kívül 400 darab 3500yl kerül fokozatosan a helyére, a 10 Gbps sebességű kapcsolatokat pedig 5400zl sorozatú switchekkel teremtik meg. Utóbbiak száma egyelőre 20, ám a következő években várhatóan 100 fölé emelkedik.

Hankó Péter

A kutatóintézetről közölt képek a CERN tulajdonát képezik, felhasználásuk a CERN előzetes írásbeli engedélyéhez kötött.